Guida pratica per scrivere prompt efficaci e ottenere il massimo dall’AI generativa

Quando interagisci con un’AI generativa (come ChatGPT, Claude, Gemini o Perplexity), non programmi: parli. Stai scrivendo una richiesta in linguaggio naturale, e questo rende il modo in cui formuli la tua domanda fondamentale per la qualità del risultato.

Questa interazione naturale è definita vibe-coding ovvero il processo creativo in cui, invece di usare linguaggi tecnici, descrivi quello che vuoi ottenere e lasci che sia l’AI a trasformare le tue idee in risultati pratici.

_La ricetta universale del prompt perfetto

Per progettare prompt efficaci, è utile conoscere la struttura del prompt e capire come interagiscono i suoi elementi fondamentali.

Tutti i modelli generativi – da OpenAI ad Anthropic – rispondono meglio quando segui questa semplice struttura in tre blocchi:

| Elemento | Cosa inserire | Perché è utile |

|---|---|---|

| Istruzione | Una richiesta chiara, come se fosse il titolo di un task. | Focalizza subito l’obiettivo dell’output. |

| Contesto | Informazioni, dati, tono, ruolo, vincoli. | Aiuta il modello a “capire” meglio cosa vuoi e cosa evitare. |

| Formato | Specifica come deve essere la risposta. | Rende il risultato più ordinato e facilmente utilizzabile. |

Esempio pratico:

- Istruzione: Analizza i dati di questa tabella e suggerisci tre possibili strategie di ottimizzazione.

- Contesto: La tabella contiene i risultati di performance di una web app nelle ultime 8 settimane.

- Formato: Risposta in tre punti elenco, ciascuno con una breve spiegazione tecnica.

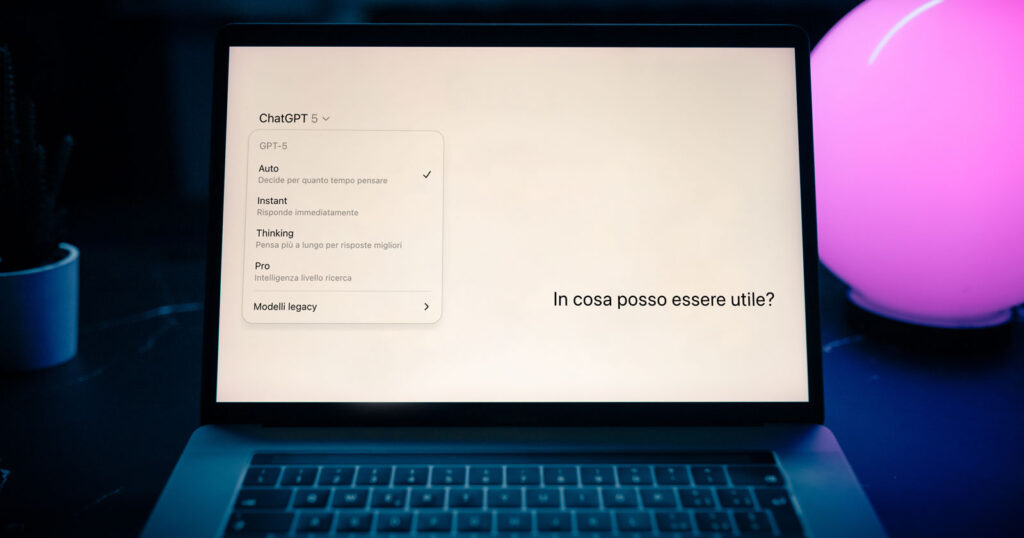

_Scegli il modello giusto… o lascia che lo scelga l’AI per te

Fino alla versione 4, in ChatGPT la scelta manuale del modello era un passaggio fondamentale: ogni modello aveva punti di forza specifici e selezionarlo in base al compito poteva fare la differenza.

Con GPT-5, questa logica è cambiata: ora ChatGPT seleziona automaticamente il motore (modello o modalità interna) più adatto alla tua richiesta, senza che tu debba impostarlo manualmente.

Il sistema “instrada” il prompt verso due principali modalità operative:

- Chat → veloce, fluida, adatta a compiti generici e interazioni rapide.

- Thinking → più lenta ma con ragionamento approfondito, ideale per analisi complesse, codifica e problemi multi-step.

Puoi comunque provare a forzare la modalità, ad esempio usando indicazioni esplicite nel prompt, ma nella maggior parte dei casi è l’AI a decidere.

Dove la scelta manuale è ancora importante

Se usi altri strumenti — come Claude, Claude Code o Perplexity — la selezione del modello rimane nelle tue mani. In questi casi puoi scegliere varianti con priorità su velocità, accuratezza o capacità di ragionamento, proprio come avveniva prima di GPT-5.

Un’alternativa può essere l’utilizzo delle API: in ambienti come l’OpenAI API o equivalenti di altri provider, hai ancora la possibilità di specificare manualmente il modello desiderato, oltre a regolare parametri come temperatura, max tokens e modalità di ragionamento. Questo approccio è particolarmente utile se vuoi integrare l’AI in applicazioni personalizzate o automatizzare processi mantenendo il pieno controllo del comportamento del modello.

Perché il prompt ora conta più di prima

Con GPT-5, il prompt è la leva principale per influenzare quale motore l’AI userà:

- Specifica complessità e output atteso (“Spiega passo-passo”, “Analisi dettagliata con citazioni”, “Risposta breve e schematica”).

- Fornisci contesto chiaro per permettere al sistema di capire se servono ragionamenti profondi o risposte veloci.

- Usa indicazioni esplicite di modalità (“Rispondi in modalità approfondita” o “Fornisci una risposta rapida e sintetica”).

Un buon prompt engineering in GPT-5 non solo migliora la qualità della risposta, ma orienta il modello verso la modalità più adatta, anche se non puoi più scegliere direttamente un GPT-4, GPT-4o o O-series.

_10 consigli sempre validi (e dove trovarli)

- L’accuratezza è il vero punto di forza Prompt vaghi, contraddittori o senza un ordine gerarchico preciso, possono compromettere la qualità del risultato: il modello spenderà tempo e risorse per tentare di conciliare indicazioni incompatibili, producendo output meno coerenti o troppo generici.

- Scrivi prima l’istruzione, poi il resto L’AI lavora top-down. Esempio:

✅ «Analizza queste metriche di performance e suggerisci miglioramenti» ❌ Iniziare allegando i dati senza dire cosa vuoi farci. - Sii specifico (senza appesantire) Indica pubblico, tono, lunghezza, output desiderato. Esempio:

«Scrivi un abstract di massimo 150 parole, usa un tono formale adatto ad un pubblico di sviluppatori.» - Mostra un esempio: one-shot o few-shot

- One-shot: un solo esempio

- Few-shot: 2–3 esempi simili

«Ecco un esempio di riassunto. Fai lo stesso con il testo seguente.» - Parti semplice, poi affina con vincoli Inizia con: «Scrivi un elenco sintetico» Poi aggiungi: «in tono ironico» o «per un pubblico di sviluppatori» se serve.

- Evita richieste vaghe

- ❌ «Scrivi qualcosa di breve»

- ✅ «Massimo 100 parole, usa esempi concreti e stile colloquiale»

- Dì cosa vuoi, non cosa evitare

- ❌ «Non essere generico»

- ✅ «Concentrati sui risultati numerici e su dati verificabili»

- Usa parole guida tecniche Esempi:

- «Inizia con: Titolo – poi elenco puntato»

- «Restituisci in formato JSON valido»

- «Scrivi in Markdown»

- Regola i parametri (se usi API o Playground) Temperatura bassa (es. 0.2) → risposte più affidabili. Utile per: analisi, fact-checking. Se lavori via API, puoi anche:

- Specificare il modello da usare (es.

gpt-4o-mini,gpt-4.5-turbo) nei provider che lo consentono. - Impostare limiti di lunghezza (

max_tokens) per controllare la quantità di testo generata. - Definire stile e tono predefiniti tramite system prompt persistenti.

- Specificare il modello da usare (es.

- Verifica periodicamente i tuoi prompt

Ripeti test mensili. Aggiorna riferimenti, esempi e vincoli.

Un buon prompt oggi può non funzionare domani.

_5 esempi pratici per iniziare subito

Prompt pattern ricorrenti da usare anche senza saper programmare:

- Role-play Chiedi all’AI di comportarsi come un esperto.

«Fingi di essere un Data Engineer: spiega questi risultati a un CTO.» - Checklist Ottimo per controlli o verifiche.

«Questa landing page rispetta le best practice UX? Rispondi con una tabella ✅/❌.» - Chain-of-thought (Catena di pensieri) Utile per problemi complessi.

«Pensa passo-passo prima di rispondere. Spiega ogni step.» - Autocritica Per migliorare l’affidabilità dell’output.

«Dopo la tua risposta, elenca tre limiti o possibili errori nella tua stessa analisi.» - Multimodale Se il modello lo supporta, fornisci anche immagini.

«Guarda questo screenshot. Trova 3 problemi di UX. Spiega ogni punto con esempi.»

_ Come trasformare un prompt in uno strumento (in 5 step)

Scrivere un prompt efficace è solo l’inizio. Ecco come trasformarlo in una risorsa scalabile e interattiva:

- Scrivi una prima versione del prompt Segui la struttura: istruzione + contesto + formato.

- Testalo su casi reali Provalo su 3–5 casi d’uso veri. Se non funziona, annota cosa non va.

- Ottimizzazione Aggiungi esempi, restringi il contesto, chiarisci i vincoli.

- Automazione Usa quel prompt in API, automazioni o strumenti no-code.

- Monitora e aggiorna Rivedi il prompt periodicamente per adattarlo a nuovi casi studio e ai nuovi aggiornamenti dei modelli.

Un prompt ben fatto può diventare uno strumento riutilizzabile, per generare contenuti, supportare attività quotidiane o velocizzare analisi ripetitive.

_Schema riassuntivo per scrivere prompt efficaci (che funzionano davvero)

Quando vuoi scrivere un prompt velocemente, ma senza sacrificare la qualità dell’output, prova a seguire questo schema:

CopiaModifica

Istruzione:

[Cosa deve fare l’AI, in una frase chiara e diretta]

Contesto:

[Info di background, dati o esempi di riferimento]

Formato:

[Specifica il tipo di output: lista, tabella, codice, markdown, JSON…]

Note:

[Tono, vincoli, lingua, pubblico: es. “Usa tono professionale”, “Massimo 200 parole”]

Questo schema ti aiuta a pensare al prompt come a una mini-spec tecnica: più chiaro sei, migliore sarà la risposta dell’AI.

_Conclusione

Il prompt engineering non è un’arte per pochi, ma una competenza strategica che chiunque può imparare con metodo. È uno strumento potente per ottenere il meglio dall’AI generativa, anche se non scrivi una riga di codice. Serve solo un po’ di chiarezza, curiosità e un pizzico di pazienza.

In Fyonda, applichiamo questi principi ogni giorno: progettiamo prompt scalabili per i nostri sistemi, li testiamo in ambienti reali e li integriamo in strumenti no-code, API e flussi operativi.

Con l’approccio giusto, l’AI può diventare il tuo alleato quotidiano: per scrivere, progettare, analizzare e ottimizzare il tuo lavoro di tutti i giorni.